Face2Face

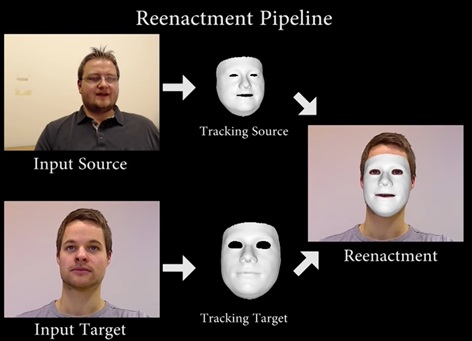

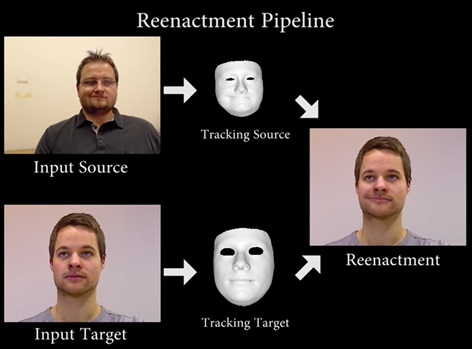

Face2Face è un approccio per la modifica dell’espressione facciale in tempo reale che trasferisce le espressioni di un video sorgente ad una destinazione video, mantenendo l’identità della persona target. Sia la sequenza video sorgente che quella destinazione possono essere riprese da webcam comuni.

Per affrontare l’approccio Face2Face, ci siamo rifatti allo studio – del team universitario di cui all’introduzione – presentato al SIGGRAPH Emerging Technologies 2016, dove ha vinto il primo premio in “Show Award”[1].

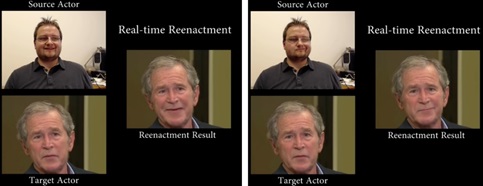

Il metodo utilizzato è risultato molto convincente nel trasferimento delle espressioni facciali da una sorgente a un video di destinazione in tempo reale. Il lavoro mostra risultati con un’impostazione live (il primo metodo di riproduzione delle espressioni facciali RGB in tempo reale), in cui il flusso video sorgente viene acquisito da una webcam e utilizzato per manipolare un video Youtube di destinazione.

[1] Permission to make digital or hard copies of all or part of this work for personal or classroom use is granted without fee provided that copies are not made or distributed for profit or commercial advantage and that copies bear this notice and the full citation on the first page. To copy otherwise, to republish, to post on servers or to redistribute to lists, requires prior specific permission and/or a fee.

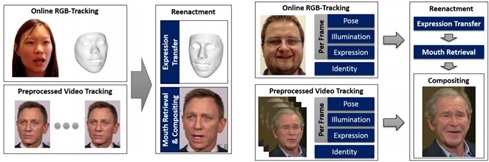

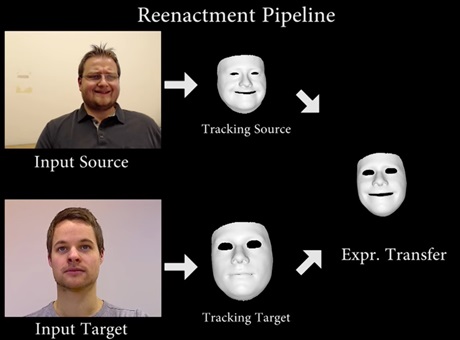

Le espressioni facciali trasferite nel video target sono quelle di un attore usato come sorgente (catturate tramite un sensore RGB), il video di output viene ricalcolato e manipolato in modo fotorealistico. Per prima cosa è necessario recuperare l’identità facciale dal video mediante raggruppamento non rigido basato su un modello 3D.

L’approccio usato prevede che in una fase di preelaborazione venga analizzato e ricostruito il volto dell’attore target.

Durante la riproduzione dal vivo, si segue l’espressione dell’attore di origine e la trasferiamo sulla faccia target ricostruita.

Infine, si compone un’immagine inedita della persona target usando l’interno della bocca della sequenza destinazione che corrisponde meglio alla nuova espressione.

Monitorando le espressioni facciali del video sorgente e di destinazione si ottiene la riproduzione delle espressioni mediante trasferimento rapido di deformazione tra sorgente e target.

Infine, si rielabora la faccia di destinazione sintetizzata sopra il flusso video corrispondente in modo da fondere perfettamente con l’illuminazione del mondo reale.

Considerazioni

Un problema rilevato su tutti gli approcci relativi al metodo Face2Face riguarda l’illuminazione dell’ambiente circonstante, che se non resa il più possibile simile al video target, può essere limitante e portare ad artefatti soprattutto in presenza di ombre o riflessi. Risulta essere ancora più problematica la situazione di soggetto target con capelli lunghi e barba.