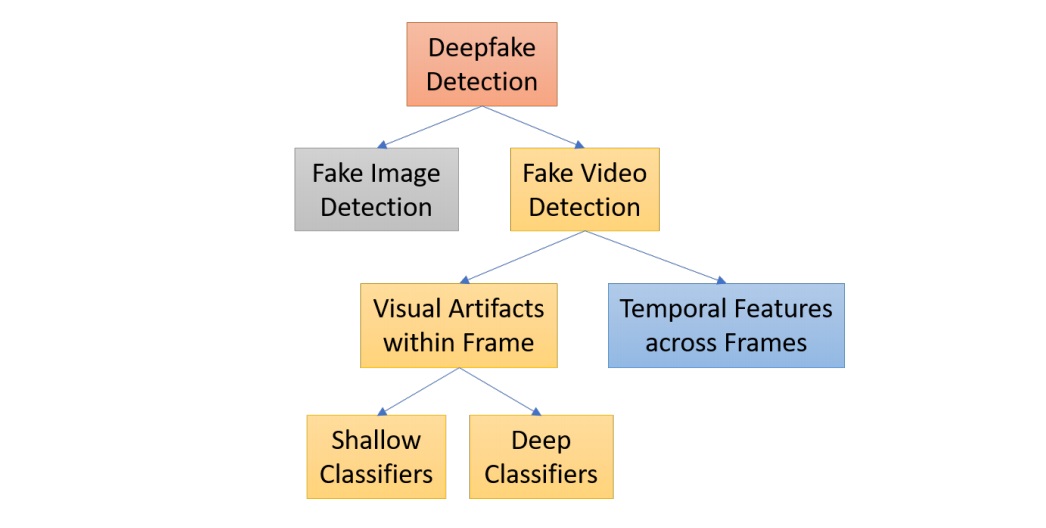

Nella figura riportata sopra, viene suddivisa la problematica della rilevazione in due macroaree di intervento, l’immagine e il video. Per quanto riguarda l’image detection, ferme restando quelle tecniche di rilevamento basate sul deep learning che ora cercheremo di scorrere, molto può essere fatto con le tecniche tradizionali, precedenti all’uscita dei deepfake, già riportate al capitolo precedente.

Per tutto il resto del fenomeno, esistono varie tecniche, tutte basate obbligatoriamente sul deep learning. Infatti, pur rimanendo valido il tentativo di ricercare il file originale a quello oggetto di studio, o semplicemente rilevando a occhio nudo determinati artefatti, l’unico sistema che può rilevare manomissione di un video realizzato tramite deep learning è il deep learning stesso. Un soggetto malintenzionato particolarmente abile nel creare un video fake, infatti, una volta che verrà realizzato un algoritmo che “smaschera” il suo lavoro, troverà il modo di affinare la tecnica e il proprio algoritmo per nascondere ulteriormente i rilievi appena evidenziati dal nuovo concorrente, e così via per l’attore buono e l’attore cattivo.

L’elemento che abbiamo riscontrato come determinante in questa lotta tra il bene e il male, è la natura e completezza del dataset utilizzato nella creazione/rilevazione del videofake. In tutti gli studi analizzati, viene fatto riferimento a dataset specifici a seconda della tecnica che è meglio utilizzare in quel momento. Vista però la crescente ottimizzazione degli algoritmi, viene consigliato, nei casi più ostici, di utilizzare più tecniche, affinché, ciò che non rileva una venga rilevato da un’altra.

I. Temporal Features across Video Frames:

si tratta di una osservazione di coerenza temporale che il processo di sintesi del deepfake non riesce ad applicare coerentemente. Il metodo è testato sul set di dati FaceForensics ++, che include 1.000 video[1] e mostra risultati promettenti.

Tra i segnali osservati, la verifica del battito di ciglia, per rilevare il deepfake è stato proposto un test sull’osservazione che una persona in deepfakes ha molti meno battiti di ciglia rispetto a quelli nei video non manomessi. Una persona adulta e sana normalmente sbatte le palpebre ad intervalli da 2 a 10 secondi e ogni lampeggio impiegherà 0,1 e 0,4 secondi.

[1] Rossler, A., Cozzolino, D., Verdoliva, L., Riess, C., Thies, J., and Niener, M. (2019). FaceForensics++: Learning to detect manipulated facial images. arXiv preprint arXiv:1901.08971

II. Visual Artifacts within Video Frame:

come visto, i metodi che utilizzano modelli temporali tra i fotogrammi video sono per lo più basati sulla ricorrenza profonda a modelli di rete per rilevare video deepfake. Con questo metodo si indaga l’altro approccio che normalmente decompone i video in frames ed esplora artefatti visivi all’interno di singoli frame per ottenere caratteristiche discriminanti. Queste funzionalità vengono quindi distribuite in un classificatore profondo o superficiale per distinguere tra video falsi e autentici. Raggruppiamo quindi i metodi in questa sottosezione in base ai tipi di classificatori, cioè profondo o superficiale.

A. Deep classifiers:

i video deepfake vengono normalmente creati con basse risoluzioni, che richiedono un approccio di deformazione del viso (cioè, ridimensionamento, rotazione e taglio) che corrispondono alla configurazione di quelli originali. A causa dell’incoerenza di risoluzione tra l’area del viso deformata e il file contesto circostante, questo processo lascia artefatti che possono essere rilevato da modelli CNN come VGG16[1], ResNet50, ResNet101 e ResNet152[2].

B. Shallow classifiers:

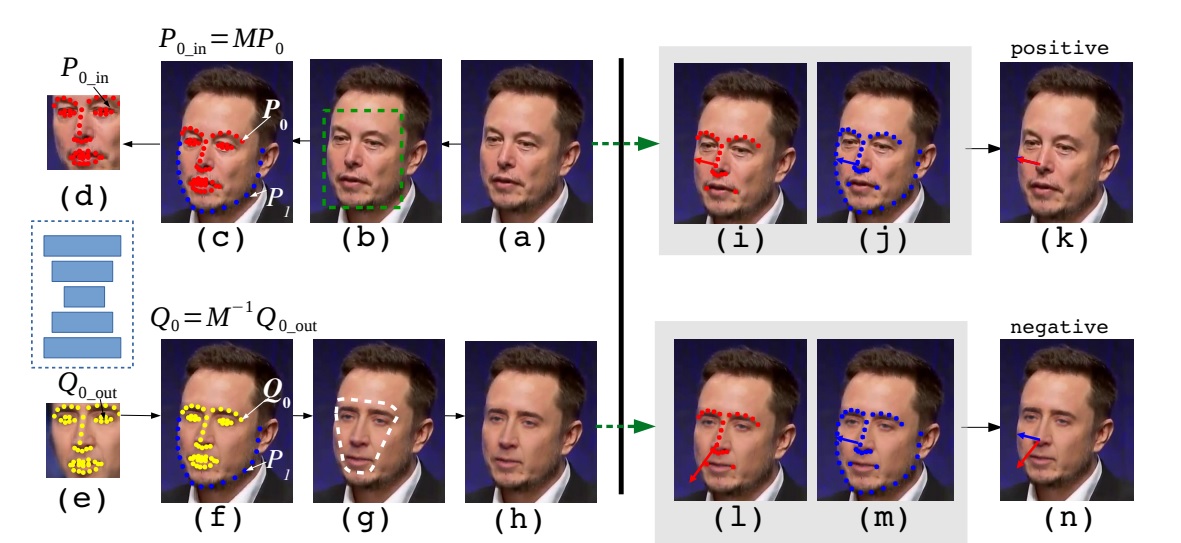

metodi di rilevamento deepfake per lo più si basano sugli artefatti o sull’inconsistenza delle caratteristiche tra immagini o video falsi e reali. Yang[3] ha proposto un metodo di rilevamento osservando le differenze tra le pose della testa 3D comprendenti l’orientamento della testa e posizione, stimata sulla base di 68 punti di riferimento facciali della regione del viso centrale.

[1] Simonyan, K., and Zisserman, A. (2014). Very deep convolutional networks for large-scale image recognition. arXiv preprint arXiv:1409.1556

[2] He, K., Zhang, X., Ren, S., and Sun, J. (2016). Deep residual learning for image recognition. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (pp. 770-778)

Ma anche: Li, Y., and Lyu, S. (2019). Exposing deepfake videos by detecting face warping artifacts. In Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition Workshops (pp. 46-52).

[3] Yang, X., Li, Y., and Lyu, S. (2019, May). Exposing deep fakes using inconsistent head poses. In 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP) (pp. 8261-8265). IEEE.

Considerazioni finali

Riteniamo che la sfida tra il bene e il male continuerà a lungo anche in questo settore. I successi delle tecniche di multimedia forensics, soprattutto quelle basate su deep learning, non devono generare false illusioni. Gli attacchi diventano anch’essi sempre più sofisticati e spesso i dati da analizzare sono fortemente deteriorati. Infatti, immagini e video vengono scambiati soprattutto sui social network, dove sono condivisi tra molti utenti e ripetutamente ri-postati, spesso ricompressi, ridotti rispetto alla loro dimensione originale, salvati in formati diversi. Rivelare una manipolazione quando un’immagine è a bassa risoluzione o fortemente compressa è un compito molto difficile perché entrambe queste operazioni tendono a nascondere le tracce della manipolazione.

Confidiamo che, come in una partita a scacchi, l’essere umano riesca ad aggiungere sempre quel granellino di creatività che sia in grado, insieme alle potenze di calcolo sempre crescenti, di dare un futuro di speranza per la ricerca del vero e del reale, anche in una dimensione ormai sempre più virtuale.